지난 포스팅에서 ollama를 이용해 로컬에서 deepseek 모델을 실행하고

Chatbox를 이용해 gpt를 사용하는 것처럼 사용해보았습니다.

그런데 그렇게 설정을 해두고 시간이 조금 흐른 후에 다시 질문을 했을 때

속도가 확연히 느려진 것을 확인하실 수 있습니다.

그 이유는 모델을 gpu나 cpu에 로딩하는 시간이 필요하기 때문입니다.

이번 포스팅에서는 첫 질문이 너무 느린 문제를 해결하기 위해

모델을 바로 언로드 하지 않도록 설정하는 방법을 공유하려고 합니다.

기본 설정 확인하기

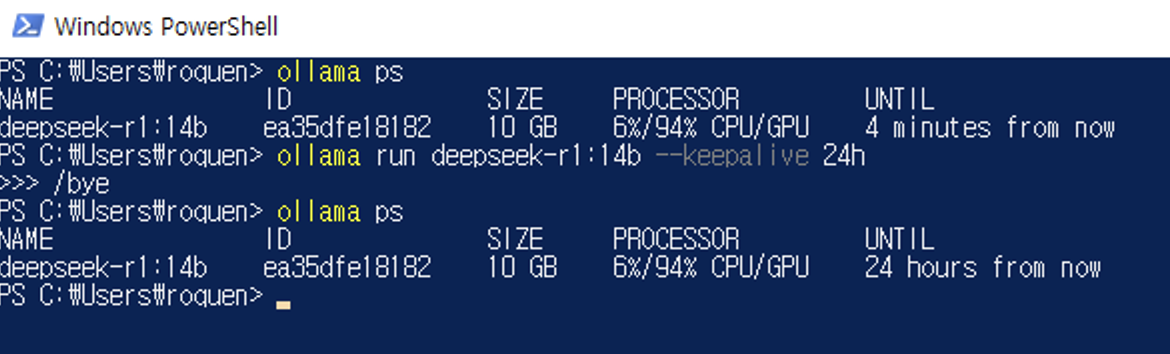

powershell에서 ollama ps라는 명령어를 입력하면 위와 같이 UNTIL 값을 확인할 수 있습니다.

이 값이 마지막 질문을 답하고 언제까지 모델을 유지할 지 설정하는 값입니다.

그래서 5분이 지나면 위와 같이 GPU 메모리에서 모델이 사라집니다.

오랫동안 모델 유지하기

위와 같이 --keepalive 옵션을 사용하면 UNTIL 값도 같이 바뀌는 것을 확인하실 수 있습니다.

이렇게 하면 하루 안에 다시 질문을 한다면 곧바로 ollama + deepseek이 대답할 것입니다.

안타깝게도 아직 영구하게 유지하는 방법을 못 찾았는데요.

다른 운영체제에서는 환경변수 OLLAMA_KEEP_ALIVE 값을 -1로 해서 설정했다는데

저는 윈도우 환경에서 해봤을 때 안되었습니다.

혹시 환경변수로 시도해보실 분은 이전 포스팅에서 환경변수 변경방법을 참고하시고

아래 명령어를 참고하여 터미널에서 환경변수가 잘 설정되었는지 확인하세요.

https://roquen4145.tistory.com/303

ollama + deepseek 설치해서 정보유출 걱정 없이 사용하기

요즘 Deepseek가 화제입니다.중국이 오픈소스를 했다는 것도 정말 의외였습니다.그래도 은연 중에 개인정보 걱정을 할 수 있는데요.오늘은 자신의 PC에 모델을 설치해서 deepseek을 안전하게 사용하

roquen4145.tistory.com

# cmd 기준

set

# powershell 기준

Get-ChildItem Env:

포스팅 읽어주셔서 감사합니다.

'학습 > AI' 카테고리의 다른 글

| ollama + deepseek 설치해서 정보유출 걱정 없이 사용하기 (0) | 2025.02.07 |

|---|