요즘 Deepseek가 화제입니다.

중국이 오픈소스를 했다는 것도 정말 의외였습니다.

그래도 은연 중에 개인정보 걱정을 할 수 있는데요.

오늘은 자신의 PC에 모델을 설치해서 deepseek을 안전하게 사용하는 방법을 공유하려고 합니다.

ollama 설치

ollama는 https://ollama.com 에 접속해서 다운로드하면 됩니다.

접속해서 보이는 download 버튼을 눌러 자신의 운영체제에 맞는 ollama를 다운로드 하세요.

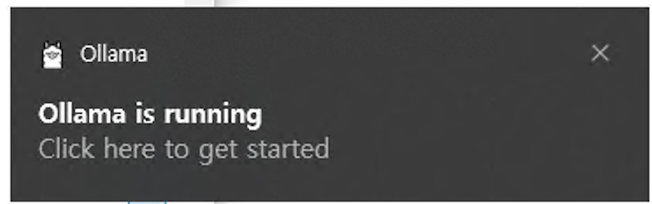

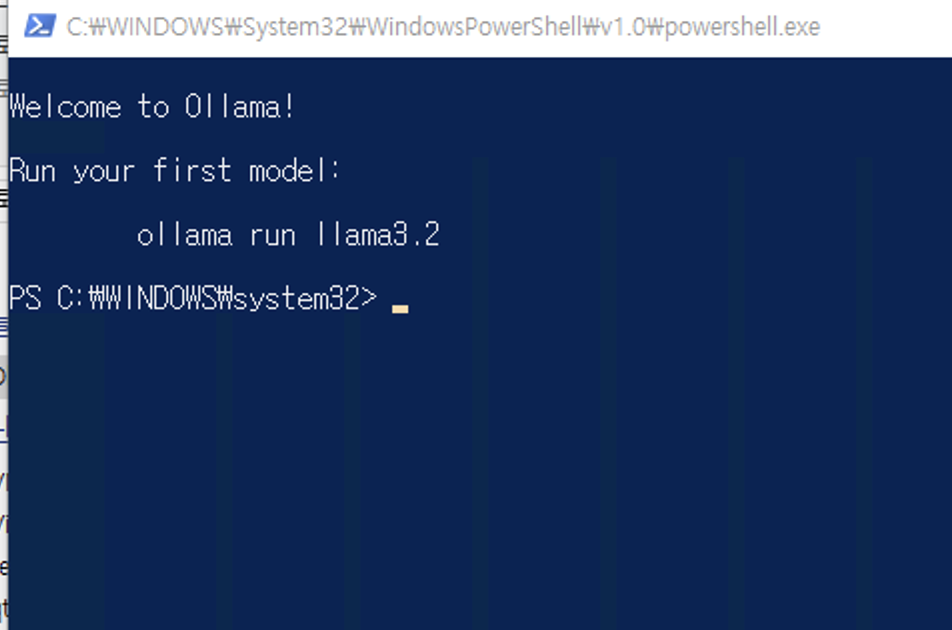

설치가 완료되면 ollama가 백그라운드로 실행됩니다.

알림을 누르면 오른쪽과 같이 powershell이 실행되면서 ollama가 정상적으로 설치된 것을 확인할 수 있습니다.

ollama 설정 (선택사항)

저는 C 드라이브 용량이 적어서 다른 드라이브에 ollama model을 다운로드하고 사용할 생각입니다.

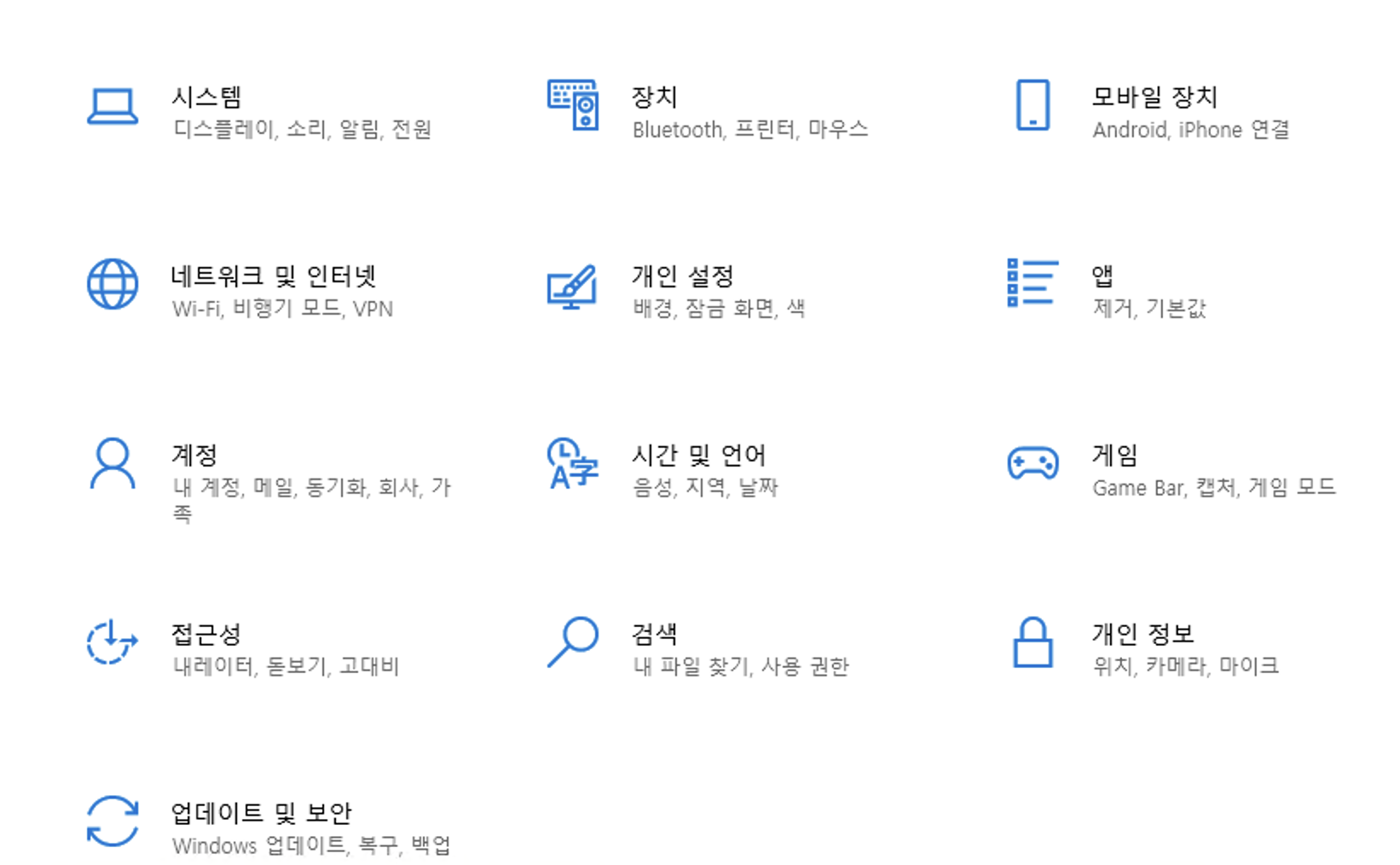

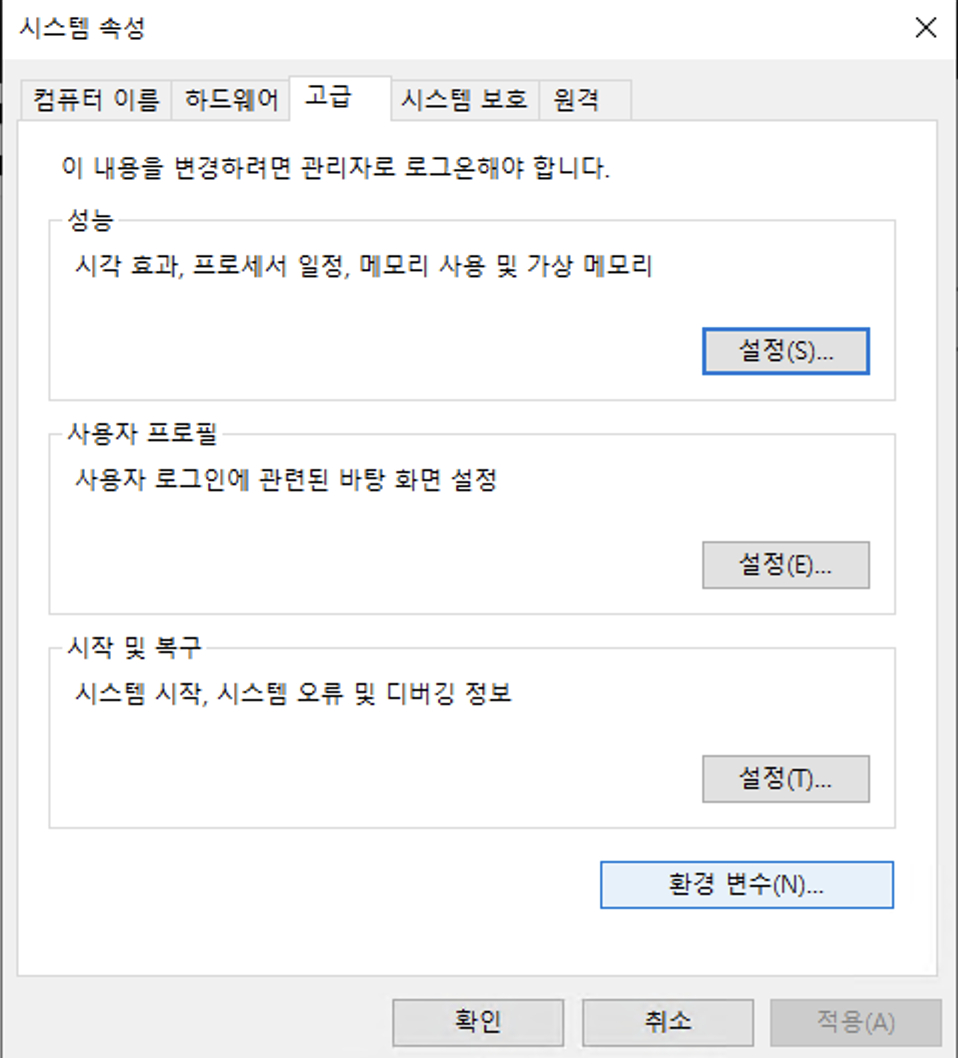

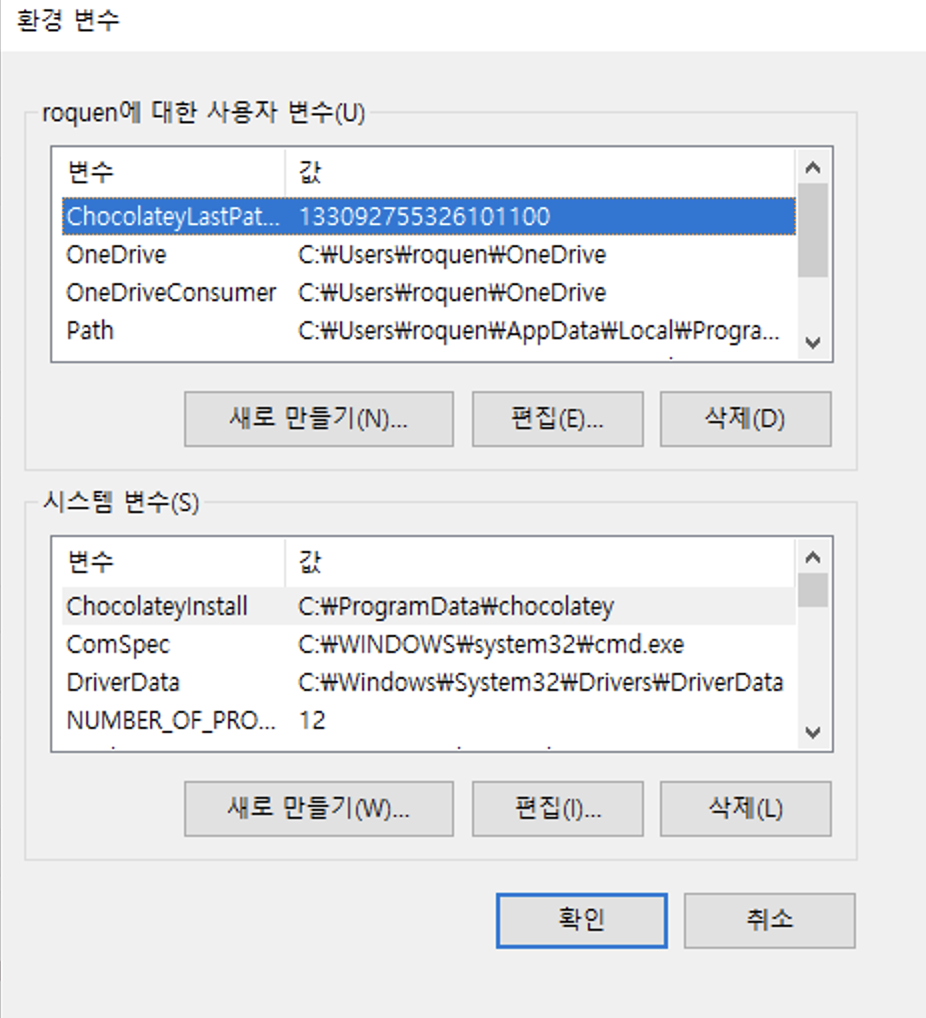

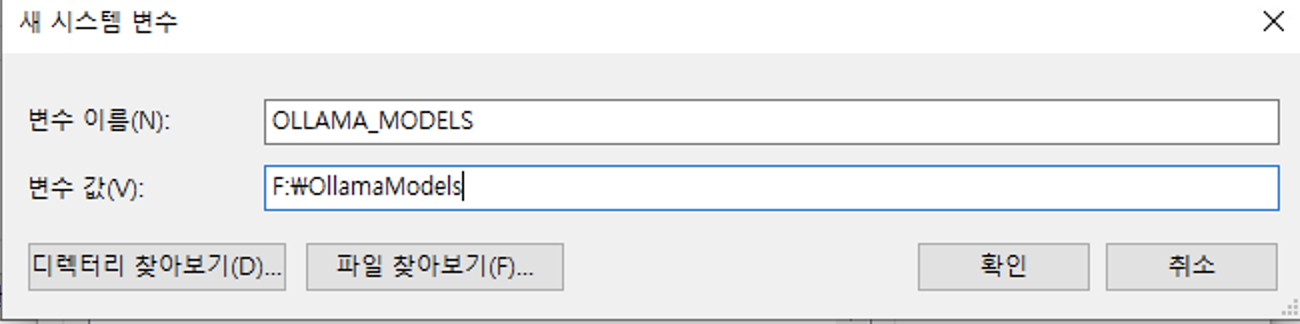

윈도우 설정에서 시스템 > 고급 시스템 설정 > 환경변수 > 시스템 변수 > 새로 만들기 를 누릅니다.

OLLAMA_MODELS 라는 이름의 변수를 만들고 원하는 경로를 입력합니다.

설정이 완료되면 ollama를 재시작 해야되는데요.

작업표시줄에 숨어있는 ollama를 우클릭해서 종료하고 다시 실행합니다.

실행은 시작 메뉴를 누르면 아이콘이 있습니다.

모델 다운로드

모델 다운로드는 아래 명령어로 실행하면 됩니다.

원하는 성능과 용량에 따라 선택해서 설치하시면 됩니다.

# 1.5B version (1.1GB)

ollama run deepseek-r1:1.5b

# 8B version (4.9GB)

ollama run deepseek-r1:8b

# 14B version (9.0GB)

ollama run deepseek-r1:14b

# 32B version (20GB)

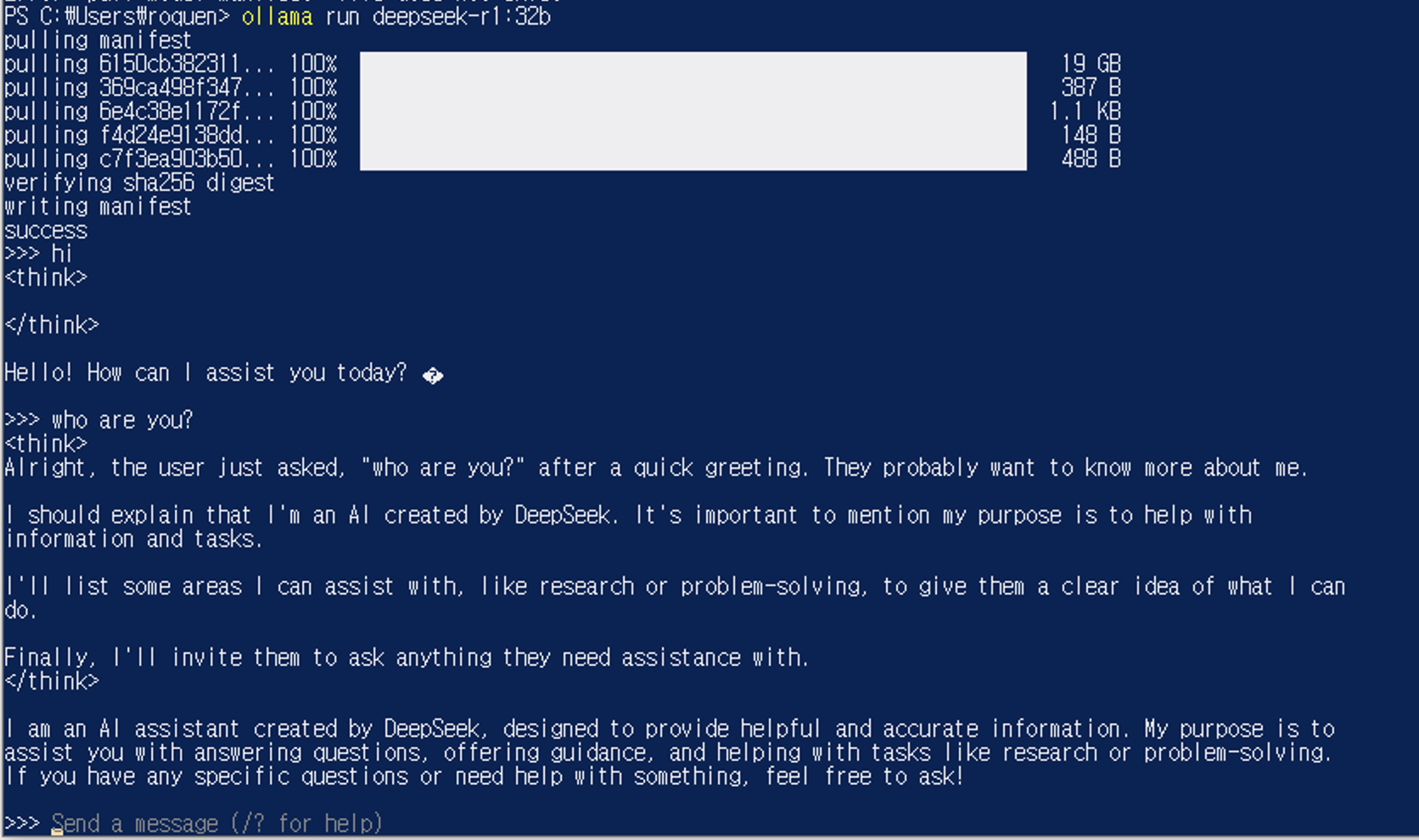

ollama run deepseek-r1:32b

# 70B version (43GB)

ollama run deepseek-r1:70b

저는 70b을 다운로드 해봤는데 RAM을 33GB 요구해서 32b로 다시 다운로드 했습니다.

deepseek가 아닌 다른 모델을 사용하려면 https://ollama.com/search 에서 검색해보세요.

deepseek 사용

설치가 완료되면 바로 채팅을 할 수 있습니다.

생각보다 속도는 느립니다.

그래서 14b를 다운받아서 하니까 속도가 일반 서비스 사용하는 것과 비슷해졌습니다.

제 환경에서는 14b를 사용해야겠습니다.

여러분도 환경에 맞는 모델을 사용하세요.

deepseek 활용

터미널에서 사용하는 것은 조금 사용성이 떨어집니다.

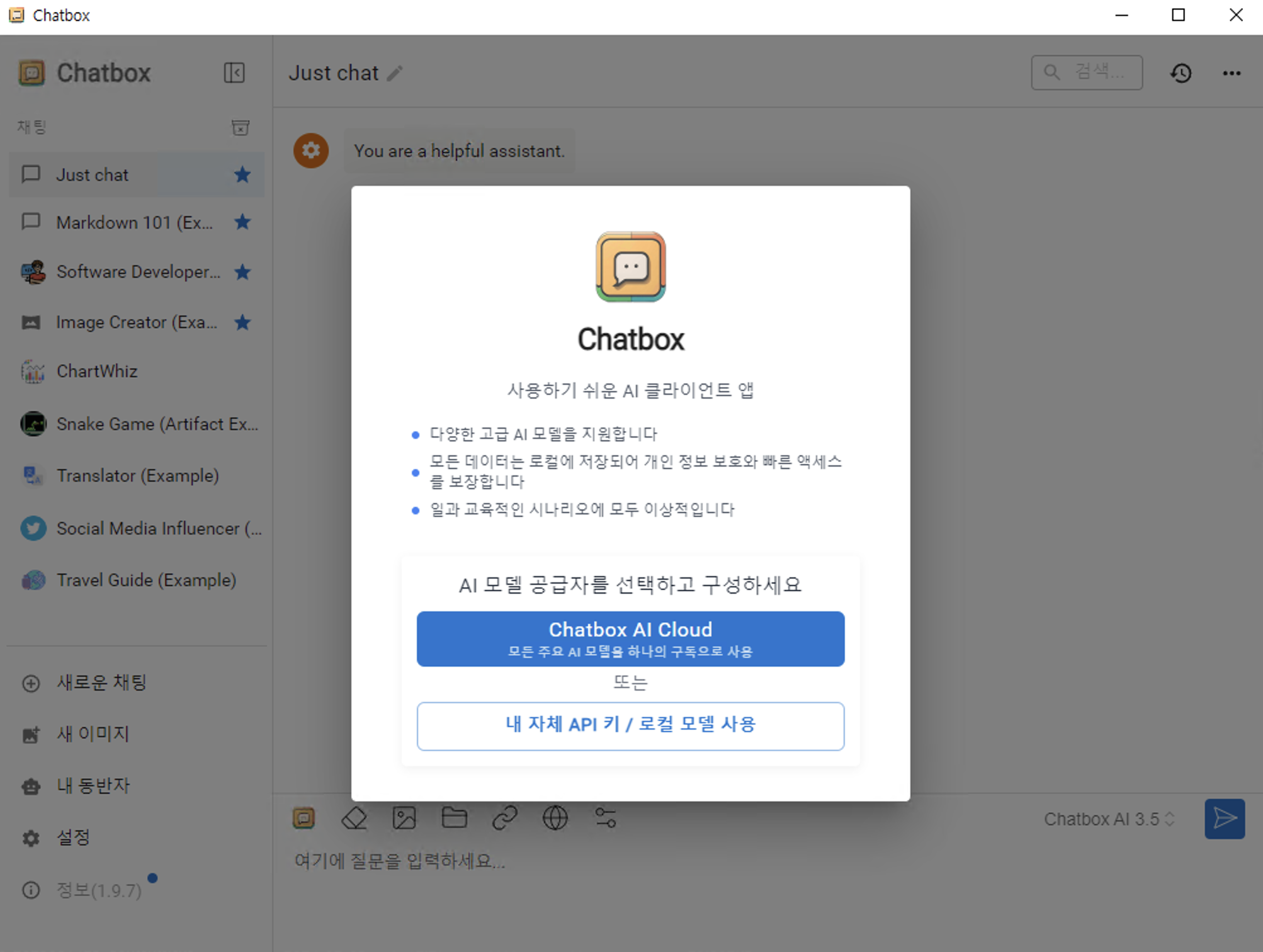

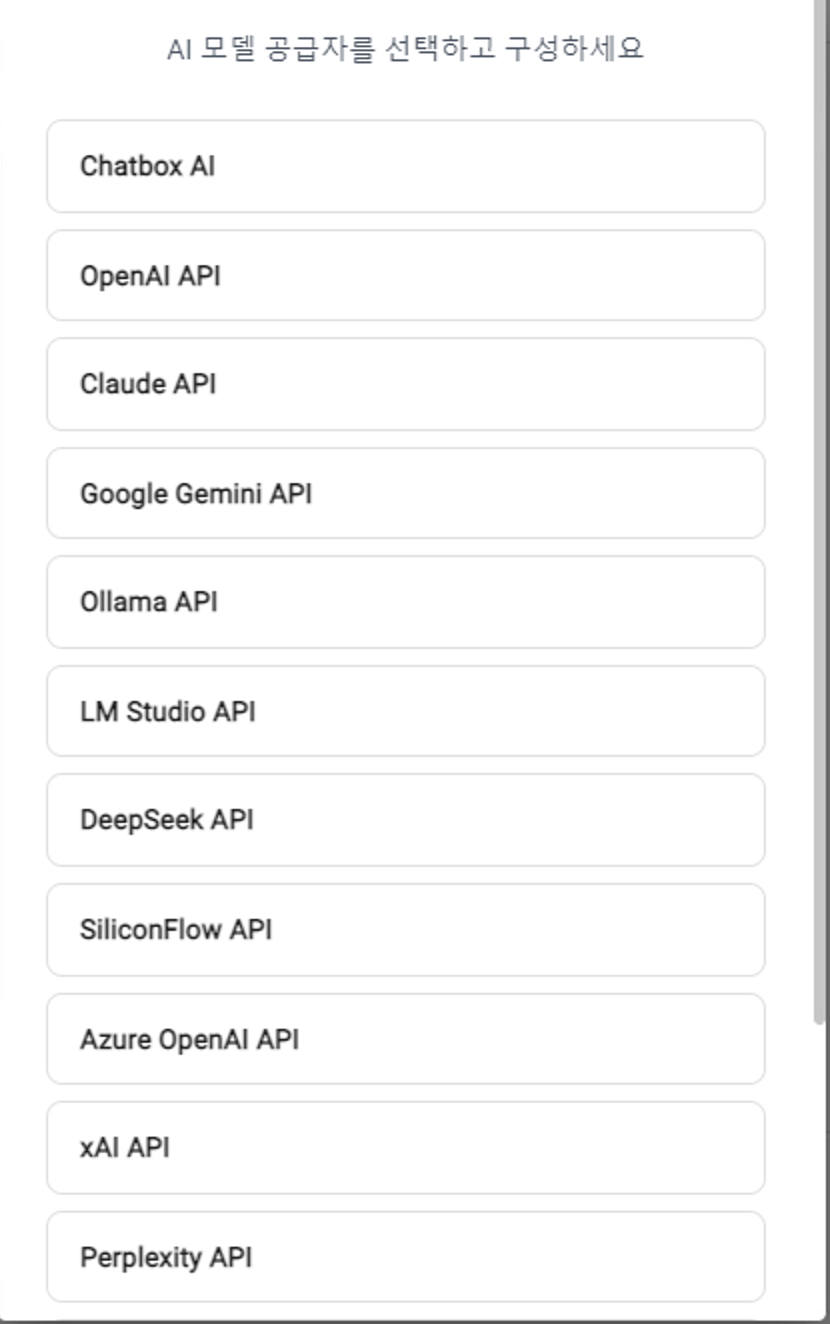

우리가 사용하는 일반 서비스처럼 deepseek를 사용하기 위해 아래 소프트웨어를 다운로드 해줍니다.

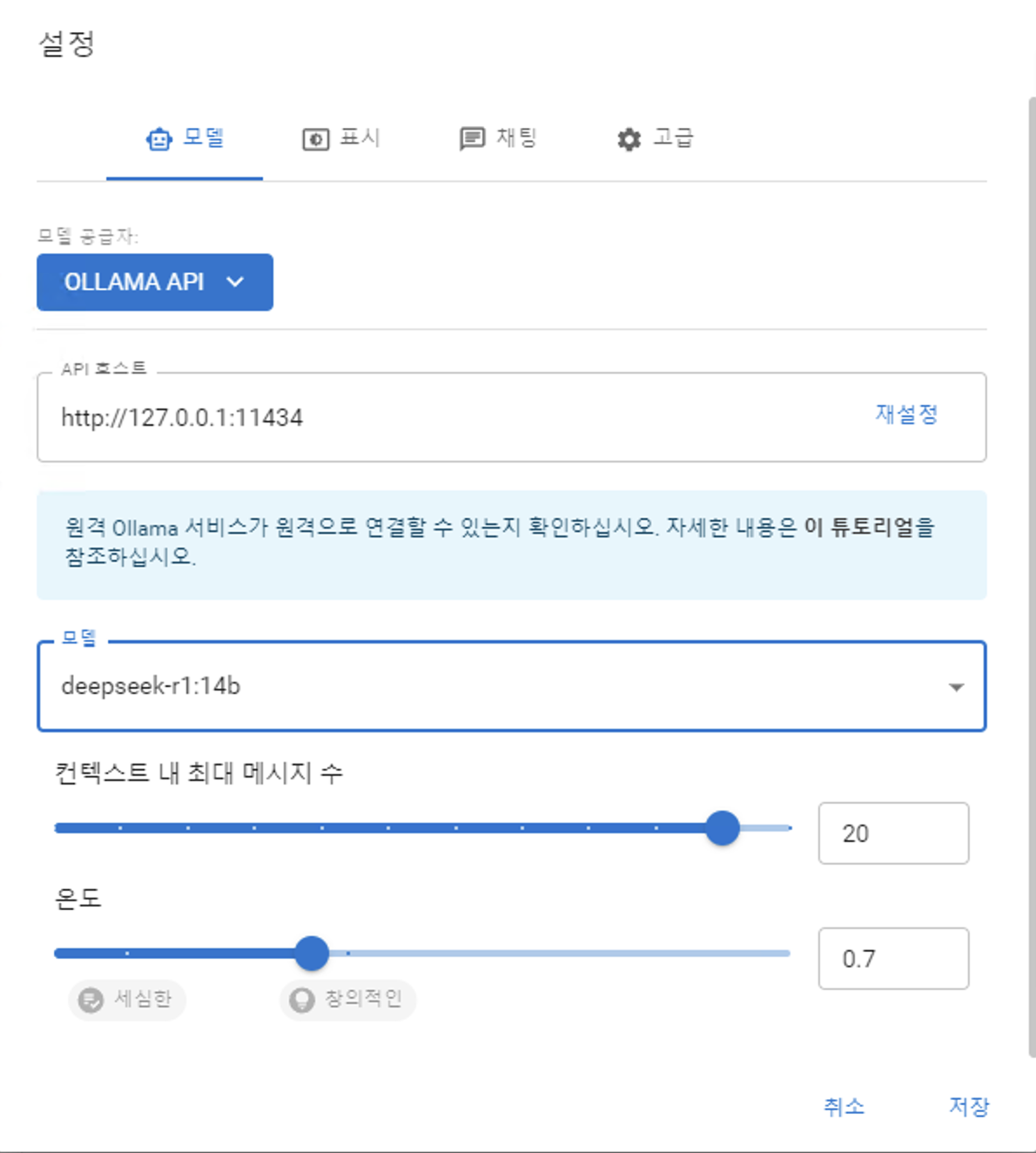

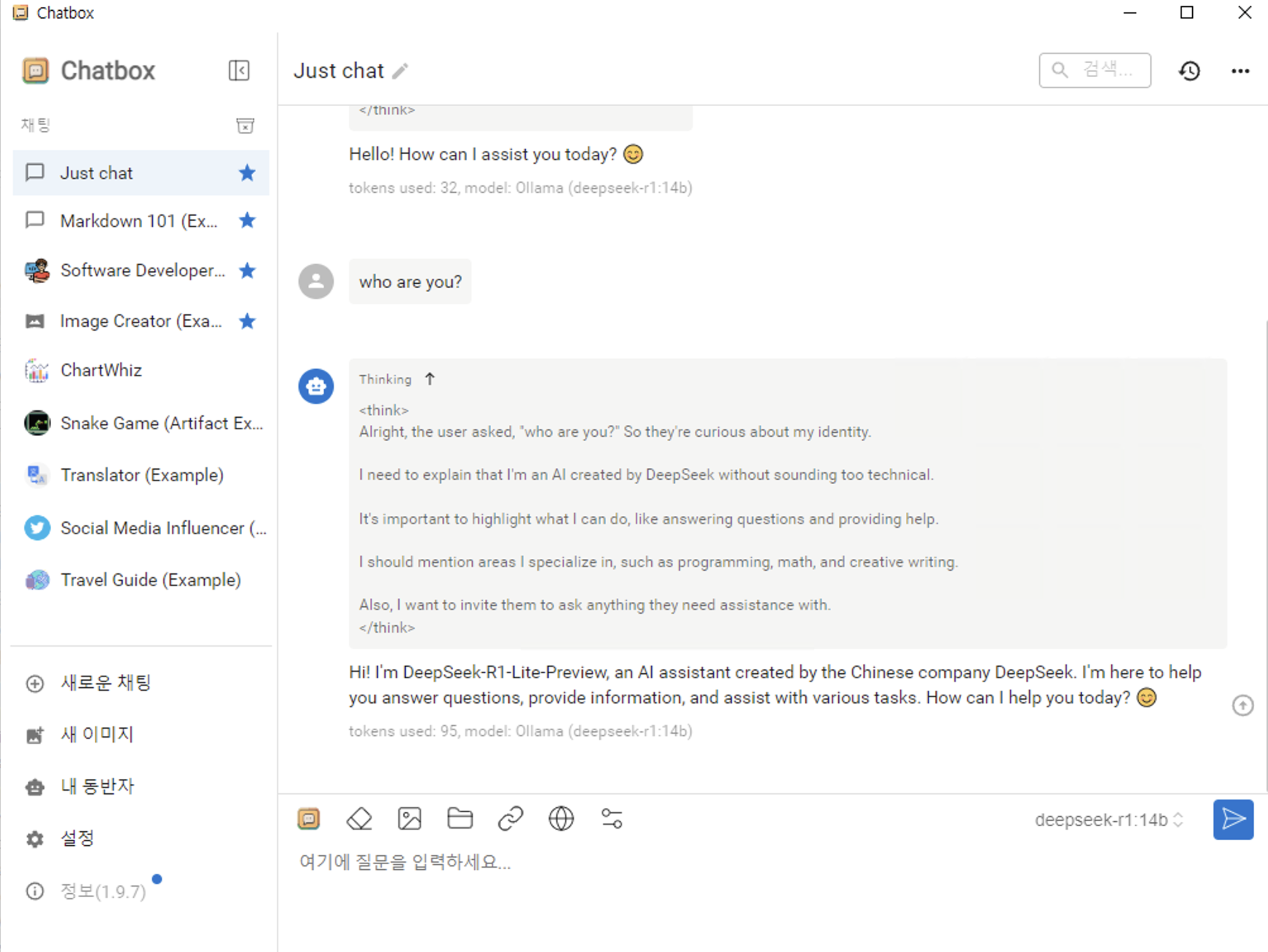

설치 후에는 로컬 모델 사용, Ollama API, deepseek-r1:xbb 를 선택합니다.

설정을 완료하면 채팅창에서 deepseek와 대화를 나눌 수 있습니다.

chatbox에서 설정할 때 API Host 포트 정보를 기준으로 연결을 하는데요.

포트포워딩을 통해 다른 네트워크에서도 집에 설치된 deepseek를 사용할 수 있을 것 같습니다.

긴 포스팅 읽어주셔서 감사합니다.

아래 추가로 진행한 개선점이 있으니 참고하시길 바랍니다.

https://roquen4145.tistory.com/305

Ollama + deepseek 첫 질문이 너무 느릴 때

지난 포스팅에서 ollama를 이용해 로컬에서 deepseek 모델을 실행하고Chatbox를 이용해 gpt를 사용하는 것처럼 사용해보았습니다. 그런데 그렇게 설정을 해두고 시간이 조금 흐른 후에 다시 질문을 했

roquen4145.tistory.com

'학습 > AI' 카테고리의 다른 글

| Deep Learning for Computer Vision : Backpropagation, Intuitions (0) | 2025.04.27 |

|---|---|

| Deep Learning for Computer Vision : Optimization (0) | 2025.04.27 |

| Deep Learning for Computer Vision : Linear Classification (0) | 2025.04.25 |

| Deep Learning for Computer Vision : Image Classification (1) | 2025.04.23 |

| Ollama + deepseek 첫 질문이 너무 느릴 때 (0) | 2025.02.13 |